Kaum ein Thema prägt die aktuelle Diskussion rund um digitale Services so stark wie künstliche Intelligenz. Viele Chatbotanbieter versprechen heute nahezu grenzenlose Möglichkeiten: frei formulierte Antworten, scheinbar menschliche Dialoge und maximale Automatisierung durch generative KI.

Doch gerade in sensiblen Anwendungsfeldern – etwa im Bürgerservice, in der Abfallwirtschaft oder im Kundenkontakt – zeigt sich: Mehr KI führt nicht automatisch zu besseren Chatbots (vgl. Blogbeitrag „So punkten Entsorgungsunternehmen mit KI-Chatbots“), Entscheidend ist nicht, wie kreativ ein System antwortet, sondern wie verlässlich, nachvollziehbar und kontrollierbar es arbeitet.

Der aktuelle KI-Hype: Was andere Anbieter versprechen

In den letzten Monaten ist der Markt für Chatbots stark von generativer KI geprägt worden. Viele Lösungen werben mit großen Sprachmodellen, die jede Frage frei interpretieren und individuell beantworten sollen.

Diese Ansätze wirken auf den ersten Blick beeindruckend. Antworten lesen sich flüssig, Dialoge erscheinen natürlich, und der technische Fortschritt ist unübersehbar. Gleichzeitig steigen jedoch die Erwartungen – bei Nutzenden ebenso wie bei Organisationen.

Was in vielen Marketingbotschaften fehlt, ist die Frage nach der praktischen Alltagstauglichkeit solcher Systeme (siehe Beitrag „Wie Chatbots die Abfallwirtschaft zukünftig noch smarter machen“).

Generative KI-Chatbots vs. kontrollierte Antworten – ein Realitätscheck

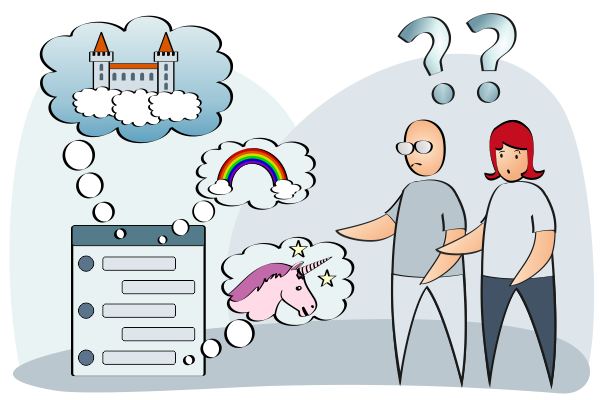

Generative KI ist darauf ausgelegt, Texte zu erzeugen – nicht zwingend, verlässliche Informationen bereitzustellen. Sprachmodelle kennen keine geprüften Fakten im klassischen Sinn, sondern berechnen Wahrscheinlichkeiten für passende Antworten.

Das kann in kreativen Kontexten sinnvoll sein. In Service-Anwendungen jedoch, in denen es um Abfuhrtermine, Gebühren, Öffnungszeiten oder rechtliche Vorgaben geht, ist diese Herangehensweise problematisch.

Hier zählt nicht sprachliche Eleganz, sondern korrekte, geprüfte Information. Genau an diesem Punkt zeigt sich der Unterschied zwischen generativer KI und bewusst gesteuerten, verlässlichen Chatbots.

Wo Halluzinationen generativer KI zum echten Risiko werden

Ein bekanntes Phänomen generativer KI sind sogenannte Halluzinationen: Antworten, die plausibel klingen, aber sachlich falsch sind. Besonders kritisch wird das, wenn Chatbots konkrete Auskünfte geben sollen – etwa zu Fristen, Zuständigkeiten oder Kosten.

Hinzu kommt: Generative Systeme kennen die lokalen Gegebenheiten einer Organisation in der Regel nicht. Sie antworten trotzdem, selbst wenn ihnen verlässliche Daten fehlen. Eine Kontrolle der Chatbot-Antworten ist häufig erst möglich, nachdem die Information bereits ausgespielt wurde.

Ein Beispiel aus der Praxis

Ein generativer KI-Chatbot wird gefragt, wann die Restmülltonne in einer Mustergemeinde geleert wird. Obwohl das System keinen Zugriff auf den Tourenplan des zuständigen Entsorgers hat, nennt es einen konkreten Termin:

„Die Restmülltonnen in der Mustergemeinde werden am Samstag, 02.05.2026 geleert.“

Diese Antwort wirkt plausibel, da viele Entsorger bei Feiertagen Leerungen auf den folgenden Samstag verlegen. Dass die konkrete Leerung in diesem Landkreis aufgrund des langen Wochenendes ausnahmsweise vorgezogen wird, weiß der Chatbot ohne verlässliche Datenquelle nicht.

Bürgerinnen und Bürger, die sich auf diese scheinbar korrekte Antwort verlassen, sind frustriert, wenn das Sammelfahrzeug bereits am vorgezogenen Termin am Grundstück vorbeifährt. Wer stattdessen auf der Website recherchiert oder den Kundenservice kontaktiert, erlebt den Chatbot nicht als Hilfe, sondern als zusätzlichen Umweg.

Konkrete – aber falsche – Termine, fehlerhafte Auskünfte zu Kosten oder Gebühren oder Links auf nicht vorhandene Formulare können in Antworten generativer KI-Systeme jederzeit auftreten.

Hinweise darauf, dass KI-Chatbots Fehler machen können, sind dabei nur ein schwacher Trost. Denn die Folgen sind klar:

- falsche Abfuhrtermine führen zu Frust und falsch bereitgestellten Tonnen,

- unsichere Informationen machen Kunden faktisch zu Beta-Testern.

Wer sich auf Antworten nicht verlassen kann, prüft sie erneut – auf der Website, per Hotline oder im persönlichen Kontakt. Statt Entlastung entsteht zusätzlicher Aufwand auf beiden Seiten. Das kostet Vertrauen, erhöht den Serviceaufwand und lässt den Chatbot an Glaubwürdigkeit verlieren.

Für Organisationen bedeutet das – neben Datenschutz und Datensicherheit (vgl. Beitrag 02/25)ein Risiko – fachlich, rechtlich und im Hinblick auf Vertrauen.

Weitere informative Blogbeiträge zum Einsatz von Chatbots und KI

Warum geprüfte Inhalte Vertrauen schaffen

Ein anderer Ansatz setzt bewusst auf Antwortkontrolle. Chatbots wie Reinbert arbeiten nicht mit frei generierten Texten, sondern greifen auf vorab geprüfte und freigegebene Inhalte zurück.

Die KI übernimmt bei diesen KI-Chatbots eine unterstützende Rolle: Sie erkennt die Absicht hinter einer Frage und ordnet ihr eine passende, geprüfte Antwort zu. Jede Antwort ist nachvollziehbar, dokumentiert und transparent steuerbar.

So entsteht Verlässlichkeit – sowohl für Nutzende als auch für die Organisation selbst (vgl. Beitrag „Barrierefreie Chatbots – die wichtigsten Aspekte für eine erfolgreiche Umsetzung“). Vertrauen entsteht nicht durch kreative Formulierungen, sondern durch konsistente, korrekte Informationen.

Wie Reinbert bewusst auf kontrollierte KI setzt

Reinbert steht exemplarisch für einen pragmatischen Umgang mit KI. Statt auf maximale Automatisierung setzt das System auf klare Prozesse, saubere Daten und vollständige Antworthoheit beim Kunden.

Die Inhalte werden zentral gepflegt, regelmäßig aktualisiert und ausschließlich dann ausgespielt, wenn sie fachlich geprüft sind. Die KI fungiert dabei als Übersetzer zwischen Frage und Antwort – nicht als eigenständiger Autor.

Zugegeben: Reinbert

- beantwortet nicht jede Frage und

- schreibt keine Gedichte.

Stattdessen ist er fachlich fokussiert, gegen Prompt-Injektionen geschützt und genau auf den jeweiligen Anwendungsfall ausgerichtet. Ob ein Chatbot Smalltalk führt oder Code erzeugt, spielt in der Abfallwirtschaft kaum eine Rolle.

Gefragt sind verlässliche Antworten auf Fragen wie:

- „Was gehört zum Sperrmüll?“

- „Was mache ich, wenn meine Tonne nicht geleert wurde?“

Dieses Prinzip hat sich überall dort bewährt, wo Verlässlichkeit wichtiger ist als sprachliche Varianz – im Bürgerservice, in der Abfallwirtschaft und in serviceorientierten Organisationen.

Fazit: Entscheidend ist, wie KI eingesetzt wird

Künstliche Intelligenz eröffnet enorme Chancen – auch für Chatbots. Doch mehr KI bedeutet nicht automatisch bessere Ergebnisse. Entscheidend ist, wie sie eingesetzt wird.

Gerade in servicekritischen Bereichen zeigt sich: Kontrolle, Transparenz und geprüfte Inhalte sind wichtiger als maximale Kreativität. Chatbots entfalten ihren größten Nutzen dann, wenn sie verlässlich informieren, Mitarbeitende entlasten und Vertrauen aufbauen.

Nicht die Menge an KI entscheidet über den Erfolg – sondern ihr verantwortungsvoller Einsatz.

Interessiert an einer präzisen Chatbot-Lösung mit 100%iger Antwortkontrolle?

⇊ Vereinbaren Sie noch heute einen Termin mit uns! ⇊